El CEO de Tinybuild admite que el editor usa herramientas de inteligencia artificial para monitorear a los empleados

El presidente de Tinybuild, Alex Nichiporchik, dice que la compañía usa inteligencia artificial para identificar a los trabajadores tóxicos, que, según el director ejecutivo, también incluyen a aquellos que están experimentando agotamiento.

Nichiporchik muestra cómo la empresa está utilizando la IA en el lugar de trabajo durante el desarrollo: la charla de Brighton titulada «IA en Gamedev: ¿Es seguro mi trabajo» introdujo una sección llamada «IA para recursos humanos» y discutió cómo se puede usar la tecnología para revisar las comunicaciones de los empleados e identificar a los trabajadores «problemáticos».

En un extracto de la charla publicada por Why Now GamingNichiporchik explica cómo el archivo hola vecinos El editor alimenta el texto de los mensajes de Slack, las transcripciones automáticas de Google Meet y Zoom y los administradores de tareas utilizados por la empresa en ChatGPT para realizar un «análisis de yo y yo» que permite a Tinybuild medir «la probabilidad de que una persona entre en agotamiento».

Nichiporchik dijo que la tecnología, que afirma haber inventado, es un «espejo negro extraño» e implica el uso de ChatGPT para monitorear la cantidad de veces que los trabajadores dijeron «yo» o «yo» en reuniones y otra correspondencia.

¿Por qué? Porque afirma que existe una «relación directa» entre la frecuencia con que alguien usa estas palabras, en comparación con la cantidad de palabras que usa en general, y la probabilidad de que experimente fatiga en algún momento en el futuro.

¿Toxicidad y fatiga? El jefe de Tinybuild afirma que son ‘lo mismo’

En particular, Nichiporchik también sugiere que la herramienta de inteligencia artificial podría usarse para identificar a los «jugadores problemáticos en el equipo» y compararlos con los «jugadores A» al buscar a aquellos que hablan mucho en las reuniones o que escriben mucho. Él llama a estos empleados «vampiros del tiempo», porque desde su punto de vista son esencialmente desperdiciadores de tiempo, y señala que «una vez que esa persona no está con la empresa o el equipo, la reunión dura 20 minutos y nos supera cinco veces más». «

En un momento, sugiere Nichiporchik, la IA se usó para identificar a un líder de estudio que no estaba en un «buen lugar» y ayudarlo a evitar el agotamiento. En la superficie, esto puede parecer una victoria, pero el CEO continúa sugiriendo que «las personas tóxicas suelen ser personas con exceso de trabajo», y agrega: «Son iguales».

Imagen a través de Why Now Gaming / Desarrollar

Igualar la toxicidad con el agotamiento es engañoso en el mejor de los casos, pero aún más preocupante es el hecho de que, al principio de la conversación, Nichiporchik habló sobre eliminar a los jugadores cuestionables de la empresa para aumentar la productividad. En este caso, eso aparentemente incluiría a aquellos que sufren de agotamiento.

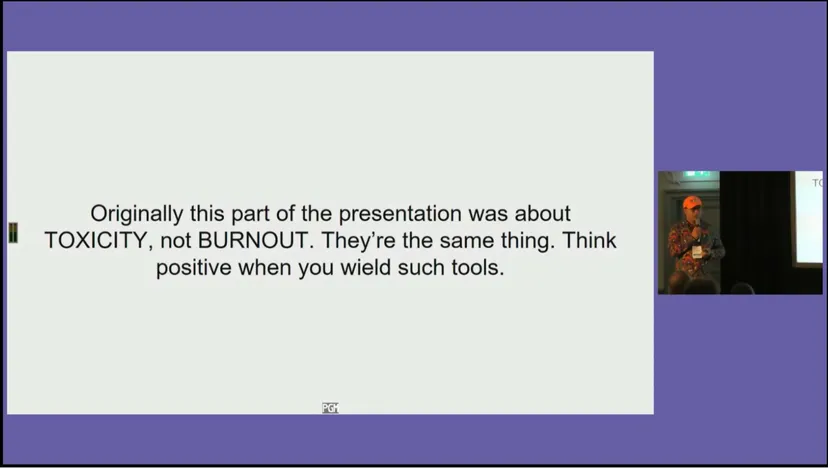

Al final de su charla, Nichiporchik dijo que las empresas deberían buscar usar las herramientas de inteligencia artificial de una manera positiva y evitar que los trabajadores «sientan que están siendo espiados». Es un consejo cuidadosamente redactado de que es posible espiar a sus empleados, pero solo si no les permite «sentirse» como si estuvieran siendo espiados.

Game Developer contactó a Tinybuild para obtener más información sobre cómo usa la IA en el lugar de trabajo.

Actualización (14/07/23): Responde a la historia original de Why Not Gaming en TwitterNichiporchik afirma que algunas de las diapositivas de su presentación se sacaron de contexto y sugiere que el uso de la IA en el lugar de trabajo «no se trata de identificar a los empleados problemáticos», sino de «proporcionar herramientas de recursos humanos para identificar y evitar que las personas se desgasten».

Nichiporchik luego señala otra diapositiva que aparece en la presentación, que dice: «El 99 por ciento de las veces que identificas el agotamiento, ya es demasiado tarde». También señala que la diapositiva del título de la sección «Inteligencia artificial para recursos humanos» se ha cambiado por una nueva diapositiva que dice «Inteligencia artificial para prevenir el agotamiento», que describe como «más sutil».

«La ética de tales procesos es ciertamente cuestionable, y esta pregunta se planteó durante la sesión de preguntas y respuestas después de la presentación», continúa Nichiporchik, y señala que se entiende que convertir la conversación de los empleados en una herramienta de inteligencia artificial en un intento de evaluar el rendimiento y el estado mental de los trabajadores. es éticamente cuestionable. «Es por eso que digo ‘área del espejo demasiado negra’. Esa parte era hipotética. Lo que puedes hacer para evitar el agotamiento».

El CEO cerró su hilo de Twitter solicitando comentarios de los asistentes de Develop: Brighton que vieron la presentación en «contexto completo».

Dijo, antes de afirmar que la cobertura de Why Now Gaming proviene de «un lugar de odio»:

actualizar (14/07/23): En una respuesta separada enviada directamente a Why Now Gaming, Nichiporchik dijo que el departamento de recursos humanos de su presentación era simplemente «virtual» y que Tinybuild no usa herramientas de inteligencia artificial para monitorear a los empleados.

La declaración dice: «La parte de recursos humanos de mi presentación era hipotética, de ahí la referencia a Black Mirror. Podría haberlo dejado más claro mirando fuera de contexto». «No monitoreamos a los empleados ni usamos la IA para identificar problemas. La presentación exploró cómo se pueden usar las herramientas de IA, y algunas de ellas entran en territorio espeluznante. Quería explorar cómo se pueden usar para siempre».