Google publicó por error documentación de investigación interna en GitHub

Imágenes falsas | Alejandro Rincón

Aparentemente, Google publicó accidentalmente un gran conjunto de documentos técnicos internos en GitHub, lo que explica en parte cómo el motor de búsqueda clasifica las páginas web. Para la mayoría de nosotros, la pregunta sobre las clasificaciones de búsqueda es simplemente «¿Mis resultados web son buenos o malos?», pero la comunidad SEO está encantada de mirar detrás de la cortina y sorprenderse de que los documentos aparentemente contradicen algo de lo que Google tiene para ofrecer. Por fin les dijo. La mayoría de los comentarios sobre la filtración provienen de expertos en SEO. Rand Fishkin Y mike rey.

Google confirmó la autenticidad de los documentos. el borde“Advertimos contra hacer suposiciones inexactas sobre la investigación basadas en información fuera de contexto, desactualizada o incompleta”, dijo. “Hemos compartido información completa sobre cómo funciona la investigación y los tipos de factores que miden nuestros sistemas, al mismo tiempo que trabajamos para lograrlo. proteger la integridad de nuestros resultados de la manipulación”.

Lo divertido de publicar accidentalmente en GoogleAPI GitHub es que, aunque se trata de documentos internos confidenciales, Google técnicamente los ha publicado bajo la licencia Apache 2.0. Esto significa que cualquiera que encontrara los documentos recibió una «licencia de derechos de autor perpetua, mundial, no exclusiva, libre de regalías e irrevocable», por lo que ahora están disponibles gratuitamente en línea, como aquí.

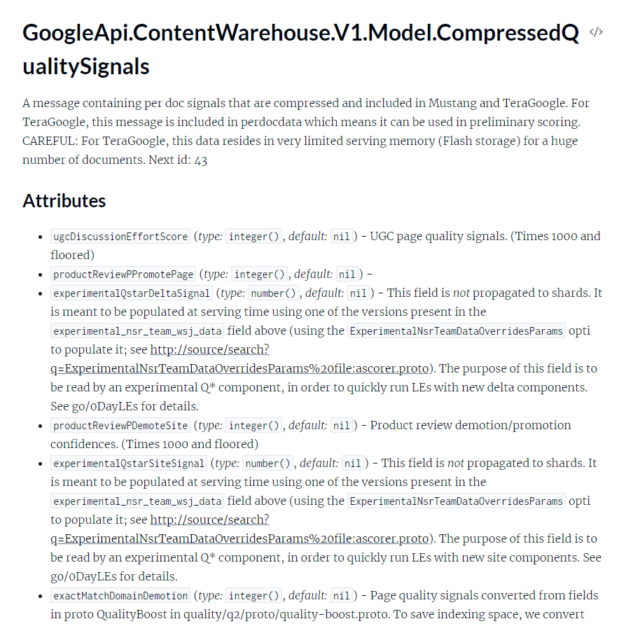

La filtración contiene mucha documentación API para «ContentWarehouse» de Google, que es muy similar a un índice de búsqueda. Como es de esperar, incluso esta visión incompleta de cómo Google clasifica las páginas web sería increíblemente compleja. King escribió que hay «2.596 módulos representados en la documentación API con 14.014 atributos». Todos estos son documentos escritos por programadores para programadores y se basan en una gran cantidad de información básica que probablemente no conocería a menos que trabajara en un equipo de investigación. La comunidad de SEO todavía está estudiando los documentos y utilizándolos para formular suposiciones sobre cómo funciona la búsqueda de Google.

Tanto Fishkin como King acusan a Google de «mentir» a los expertos en SEO en el pasado. Una de las cosas que se descubrió en los documentos es que el CTR de una lista de resultados de búsqueda afecta su clasificación, lo cual es cosa de Google. el lo negó En varias ocasiones acude a «sopa» los resultados. El sistema de seguimiento de clics se llama “Navboost”, es decir, impulsa los sitios web que visitan los usuarios. Naturalmente, gran parte de estos datos de clics provienen de Chrome, incluso cuando sales de la búsqueda. Por ejemplo, algunos resultados podrían mostrar un pequeño conjunto de resultados de mapas del sitio debajo del menú principal, parte de lo que parece ser compatible con estas subpáginas más populares según lo determinado por el seguimiento de clics de Chrome.

Los documentos también indican que Google tenía listas blancas que impulsarían artificialmente ciertos sitios web para ciertos temas. Los dos mencionados son «isElectionAuthority» e «isCovidLocalAuthority».

Gran parte de la documentación es exactamente cómo se esperaría que funcionara un motor de búsqueda. Los sitios tienen un valor «SiteAuthority» que clasificará los sitios conocidos en una posición superior a los sitios menos populares. Los autores también tienen sus propias clasificaciones, pero como ocurre con todo aquí, es imposible saber cómo interactúa todo con todo lo demás.

Ambos comentarios de expertos en SEO los hacen parecer molestos porque Google los engañe, pero ¿no necesita la empresa mantener al menos una relación ligeramente conflictiva con las personas que intentan manipular los resultados de búsqueda? Un estudio reciente encontró que «los motores de búsqueda parecen estar perdiendo el juego del gato y el ratón del spam SEO» y encontró «una relación inversa entre el nivel de optimización de la página y su experiencia percibida, lo que sugiere que el SEO puede al menos dañar la calidad subjetiva de la página». .” Ninguna parte de esta documentación adicional será beneficiosa para los usuarios ni para la calidad de los resultados de Google. Por ejemplo, ahora que la gente sabe que el CTR afecta las clasificaciones de búsqueda, ¿no podría mejorar el listado de su sitio web con una granja de clics?