Intel revela nuevos detalles sobre Meteor Lake VPU Block, presenta la visión para la IA del cliente

Si bien los primeros sistemas se basan en el próximo Intel Meteor Lake (14y Los sistemas Gen Core aún estarán disponibles durante al menos unos meses y, por lo tanto, están muy lejos de presumir en Computex. Intel ya está sentando las bases para el muy esperado lanzamiento de Meteor Lake. En la feria de este año, en lo que rápidamente se está convirtiendo en un evento centrado en la IA, Intel utiliza Computex para delinear su visión de la inferencia de IA del lado del cliente para la próxima generación de sistemas. Esto incluye algunas revelaciones nuevas sobre el hardware de procesamiento de IA que estará en los dispositivos Intel Meteor Lake, así como lo que Intel espera que hagan los sistemas operativos y los desarrolladores de software con las nuevas capacidades.

Naturalmente, la IA se ha convertido rápidamente en la palabra de moda en la industria de la tecnología en los últimos meses, especialmente después del lanzamiento público de ChatGPT y el aumento del interés en lo que ahora se llama “IA generativa”. Entonces, al igual que las primeras etapas de adopción de otras nuevas tecnologías informáticas importantes, los proveedores de hardware y software todavía están en el proceso de determinar qué se puede hacer con esta nueva tecnología y cuáles son los mejores diseños de hardware para potenciarla. Y detrás de todo… digamos que hay muchos ingresos potenciales esperando a aquellas empresas que tengan éxito en esta nueva carrera de IA.

Intel, por su parte, no es ajeno al hardware de IA, aunque ciertamente no es un área que generalmente recibe la mejor facturación en una empresa conocida por sus CPU y fábricas (en ese orden). Las filiales de propiedad total de Intel en esta área incluyen Movidius, que fabrica unidades de procesamiento de visión (VPU) de bajo consumo, y Habana Labs, que es responsable de la familia de aceleradores de aprendizaje profundo de vanguardia de Gaudí. Pero incluso dentro de los productos para clientes de etiquetado y archivo de Intel, la compañía ha incluido hardware de núcleo de vecindario de IA de muy baja potencia en la forma de su suite Gaussian & Neural Accelerator (DNA) para procesamiento de audio, que ha estado en la familia Core desde la arquitectura del lago de hielo.

Sin embargo, en 2023, el viento sopla claramente en la dirección de agregar más máquinas de IA en todos los niveles, desde el cliente hasta el servidor. Entonces, para Computex, Intel está revelando un poco más sobre sus esfuerzos de IA en Meteor Lake.

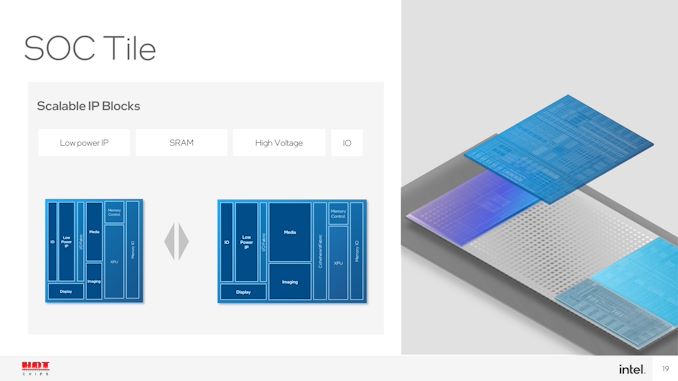

Meteor Lake: el SoC Tile incluye una VPU derivada de Movidius para la inferencia de IA de bajo consumo

En cuanto al hardware, la gran revelación de Intel es que, como sospechábamos desde hace mucho tiempo, Intel está almacenando parte de su hardware de IA más potente en su SoC calificado. Anteriormente documentado en algunas ofertas de Intel como un bloque “XPU” dentro de su mosaico Meteor Lake SoC (cuadrado central), Intel ahora confirma que este XPU es un bloque de aceleración de IA completo.

Específicamente, el bloque se deriva del diseño de la Unidad de procesamiento de visión (VPU) de tercera generación de Movidius y, en el futuro, Intel lo identifica adecuadamente como una VPU.

La cantidad de detalles técnicos que proporciona Intel en un bloque de VPU para Computex es limitada: no tenemos cifras de rendimiento ni idea de cuánto espacio de matriz de SoC ocupa. Pero la última VPU de Movidius, Myriad X, incluía un motor de computación neuronal bastante flexible que era responsable de darle a la VPU sus capacidades de red neuronal. El motor en Myriad X tiene una calificación de 1 TOPS de rendimiento, aunque casi 6 años y varias décadas prácticas más tarde, es casi seguro que Intel apunta mucho más a Meteor Lake.

Dado que es parte del mosaico SoC de Meteor Lake, la VPU estará presente en todos los SKU de Meteor Lake. Intel no lo usaría como selector de funciones, en ECC o incluso para gráficos integrados; Por lo tanto, será una característica esencial disponible para todas las partes basadas en Lake Meteor.

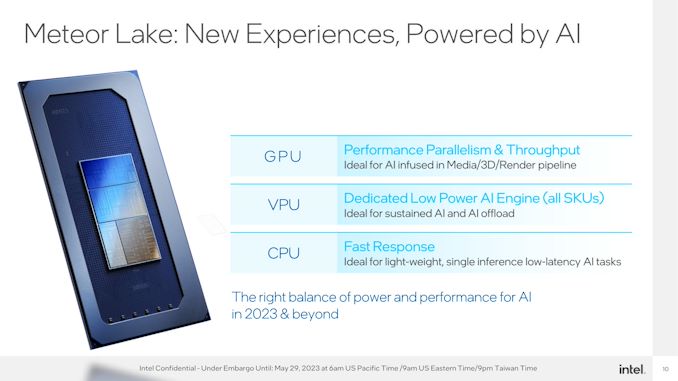

El propósito de la VPU, a su vez, es proporcionar una opción de tercer carril para el procesamiento de IA. Para las necesidades de alto rendimiento, hay una GPU integrada, cuya gran variedad de ALU puede proporcionar cantidades relativamente abundantes de procesamiento para la matriz matemática detrás de las redes neuronales. Mientras tanto, la CPU seguirá siendo el procesador elegido para cargas de trabajo simples y de baja latencia que no pueden esperar a que se inicialice la VPU, o donde el tamaño de la carga de trabajo simplemente no justifica el esfuerzo. Esto deja a la VPU en el medio, como un acelerador de IA dedicado pero de bajo consumo para cargas de trabajo continuas de IA que no necesitan el rendimiento (y el golpe de potencia) de la GPU.

También vale la pena señalar que, si bien no está explícitamente en los esquemas de Intel, el bloque GNA también estará presente en Meteor Lake. Su especialidad es la operación de muy baja potencia, por lo que todavía se necesitan cosas como despertar con sonido y compatibilidad con el software habilitado para GNA existente.

Después de eso, queda mucho que no sabemos sobre la VPU de Meteor Lake. El hecho de que incluso se llame VPU e incluya tecnología Movidius significa que es un diseño centrado en la visión por computadora, similar a las VPU separadas de Movidius. Si es así, la VPU de Meteor Lake puede sobresalir en el manejo de cargas de trabajo visuales, pero carece de rendimiento y flexibilidad en otras áreas. Y aunque la revelación de hoy de la revelación de Intel trae rápidamente a la mente preguntas sobre cómo este bloque se compara en rendimiento y funcionalidad con la suite derivada de Ryzen AI de AMD, esas son preguntas que tendrán que esperar otro día.

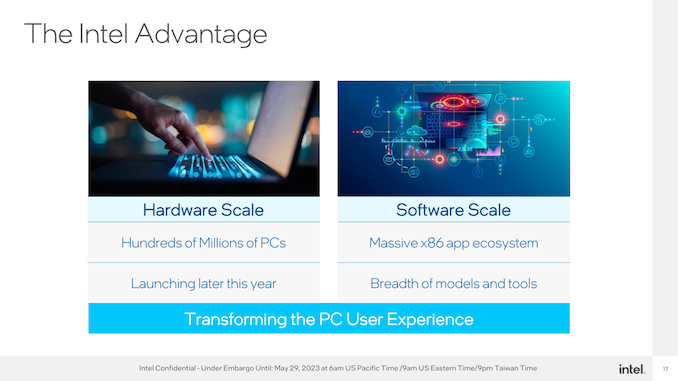

Por ahora, al menos, Intel se siente bien posicionado para liderar la transformación de la IA en el espacio del cliente. Y quieren que el mundo lo sepa, tanto los desarrolladores como los usuarios.

Lado del software: ¿Qué haces con la IA?

Como se mencionó en la introducción, el hardware es solo la mitad de la ecuación cuando se trata de software de aceleración de IA. Más importante que qué ejecutar en él es qué hacer con él, y eso es algo en lo que Intel y sus socios de software todavía están trabajando.

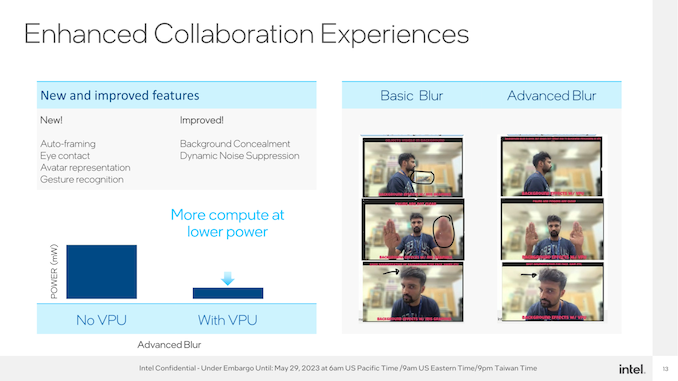

En el nivel más simple, la inclusión de una VPU proporciona un rendimiento adicional de ahorro de energía para realizar tareas que ya dependen de la IA de una forma u otra hoy en día en algunas plataformas, como la supresión dinámica de ruido y la segmentación de fondo. En este sentido, la inclusión de una VPU se está poniendo al día con los SoC de clase de teléfono inteligente, donde cosas como Neural Engine de Apple y Hexagon NPU de Qualcomm brindan una aceleración similar en la actualidad.

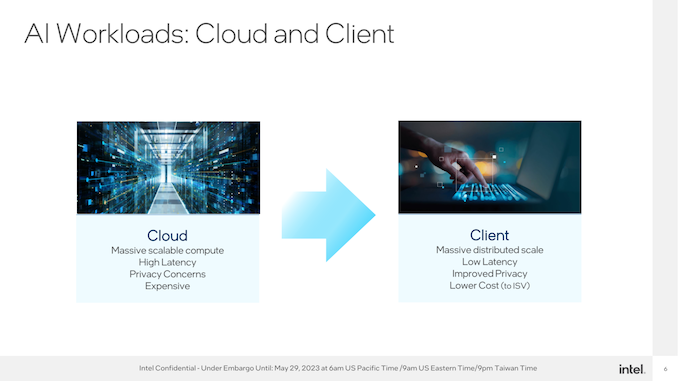

Pero Intel tiene la vista puesta en un premio mucho mayor. Ambos quieren promover el traslado de las cargas de trabajo del servidor de IA existentes al borde, en otras palabras, trasladar el procesamiento de IA al cliente, así como promover cargas de trabajo de IA completamente nuevas.

Lo que son, en este punto, está por verse. Microsoft lanzó algunas de sus propias ideas la semana pasada en su conferencia anual Build, incluido el anuncio de la Funcionalidad de copiloto para Windows 11. El proveedor del sistema operativo también está sentando las bases para los desarrolladores con el tiempo de ejecución Open Neural Network Exchange (ONNX).

Hasta cierto punto, todo el mundo de la tecnología está en un punto en el que tiene un nuevo martillo, y ahora todo comienza a parecerse a un clavo. Intel, por su parte, ciertamente no se quedó fuera, ya que la revelación de hoy es más ambiciosa que los beneficios específicos en el lado del software. Pero estos son realmente los primeros días de la IA, y nadie tiene una buena idea de lo que puede o no puede hacer. Claro, hay algunos clavos para martillar.

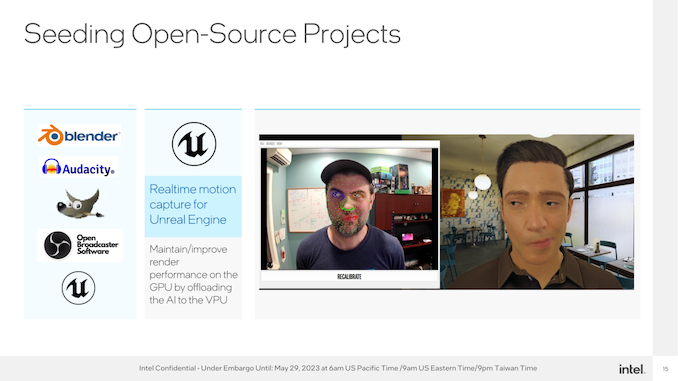

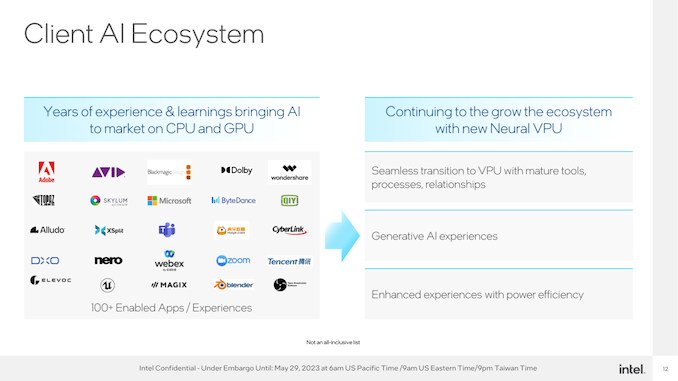

Con ese fin, Intel está buscando fomentar un ecosistema de IA de “construir y venir” en el espacio de la PC. Proporcione hardware en todos los ámbitos, trabaje con Microsoft para proporcionar las herramientas de software y las API necesarias para usar el hardware, y vea qué nuevas experiencias pueden generar los desarrolladores o, alternativamente, qué cargas de trabajo pueden cambiar a una VPU para reducir el uso de energía.

En última instancia, Intel predice que las cargas de trabajo basadas en IA cambiarán la experiencia del usuario de la computadora. Ya sea que eso suceda por completo o no, es suficiente para garantizar que el hardware haga el trabajo en la próxima generación de CPU.

“Troublemaker. Beer lover. Total alcohol aficionado. Subtly charming zombie addict. Lifelong Twitter ninja.”